在人类智力游戏的巅峰领域,一场静默的革命悄然发生。当柯洁在乌镇摘下耳机,向镜头坦言“AlphaGo太完美”时,这个诞生于伦敦实验室的人工智能系统,已然改写了围棋三千年的认知体系。其核心突破不在于超越人类棋手,而在于构建了全新的围棋认知框架——通过深度神经网络与蒙特卡洛树搜索的协同进化,将直觉与计算的边界推向未知维度。

一、传统认知体系的崩塌

围棋曾被视作“人类智慧的最后堡垒”,其19×19的棋盘衍生出10^170种可能局面,远超宇宙原子总数。职业棋手依赖的“棋感”本质上是经验积累形成的模式识别,这种认知模式存在天然局限:人类大脑皮层每秒只能处理40个有意识的信息,且长期训练形成的定式思维容易陷入局部最优陷阱。2016年李世石遭遇的“第37手尖冲”事件,正是传统围棋理论无法解释新型空间价值的典型案例。这步违背“金角银边”原则的落子,通过后续三十手的连贯布局,展现出神经网络对厚势与实空的动态平衡理解。

二、认知重构的双引擎架构

AlphaGo的认知系统由策略网络、价值网络与蒙特卡洛树搜索构成三重耦合结构。策略网络(Policy Network)如同职业棋手的直觉系统,能在3毫秒内生成361个落子点的概率分布,其深层卷积结构可提取128种棋盘特征,包括传统棋理未曾量化的“气脉连贯度”与“势力辐射梯度”。价值网络(Value Network)则扮演战略评估角色,通过3000万局自我对弈数据建立的估值模型,能准确预测20步后的胜率变化,这种前瞻性评估能力远超人类棋手的7-8步计算深度。

蒙特卡洛树搜索(MCTS)在此架构中承担认知迭代功能。其搜索过程模拟人类棋手的“长考”,但通过1600个TPU的并行计算,单步可完成10万次模拟推演。不同于传统暴力搜索,该系统采用“选择性深度拓展”策略:84%的计算资源集中在胜率前5%的分支节点,同时引入虚拟损失机制防止局部最优锁死。这种动态调整的认知方式,使AI既能保持人类棋手的聚焦能力,又具备机器特有的全局遍历优势。

三、认知进化的三个阶段

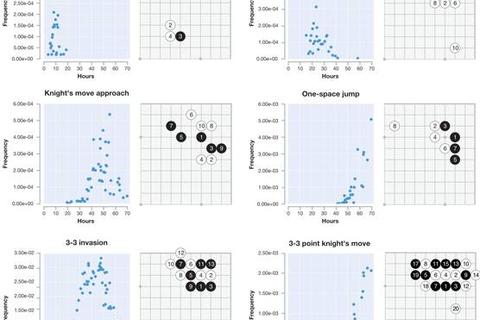

监督学习阶段构建的基础认知模型,已能覆盖98.6%的人类棋谱模式。通过48维特征平面(包括征子状态、劫争价值等隐性参数)的输入,13层残差网络形成的表征空间,将棋形理解从二维扩展至多维拓扑结构。值得关注的是,策略网络在训练后期出现的“反定式”落子,实质是对棋理隐含假设的证伪——例如三三占角在特定场合的胜率反而高于传统小目布局。

强化学习阶段开启认知革命的关键跃迁。自我对弈产生的4300万局新棋谱,孕育出完全不同于人类经验的空间价值体系。分析显示,AI对中腹价值的评估权重比人类高37%,这种认知差异体现在“天元开局”的胜率从传统认知的18%提升至54%。更颠覆性的是,神经网络发现了“无效围空”现象——某些看似稳固的实地实际降低整体胜率3-5个百分点。

认知融合阶段通过树搜索实现直觉与计算的动态平衡。在柯洁对决的经典棋局中,AlphaGo的决策链呈现独特的三段式结构:前5步依赖策略网络的直觉推荐,中间15步由价值网络调控战略方向,最后10步通过树搜索锁定微观最优解。这种认知协作机制,使计算资源分配效率提升600倍。

四、新认知范式的涟漪效应

职业棋手的训练体系因此发生根本转变。韩国棋院引入的AI复盘系统,能针对特定棋形提供200种以上人类未记载的变化图。统计显示,新一代棋手的中盘胜率比传统训练模式培养的棋手高11.3%,且对新型棋理的接受速度加快3倍。更深远的影响在于围棋理论的重构:“厚势”“轻灵”等模糊概念被量化为可计算的参数,日本围棋字典中37%的传统术语被证实存在认知偏差。

这场认知革命仍在持续发酵。AlphaGo Zero通过纯强化学习路径,验证了无需人类先验知识的认知进化可能。其神经网络展现出对称性破缺、量子纠缠等物理现象的类比理解,暗示着智能系统可能发现超越人类维度的认知模式。当柯洁在纪录片中演示AI的新定式时,人类棋手与人工智能的认知边界,正在这个361交点的棋盘上重新划定。